大数据课程中,跨组件数据同步是核心实验内容!这份文档专为学生设计,从 Sqoop 环境搭建到多场景数据流转,步骤精简无冗余,适配课程实验报告与作业提交需求,帮你轻松搞定 Sqoop 全流程操作!

一、文档核心价值

- 适配学生场景:基于 Linux 虚拟机操作,匹配学校实验室环境,硬件门槛低,无需额外配置;

- 聚焦实用操作:只讲实验必需步骤,避开复杂理论,快速完成课程要求;

- 解决实验痛点:提前覆盖安装、数据互导中的常见问题,附简单解决方案,减少报错困扰。

二、文档内容概览

1. Sqoop 安装配置

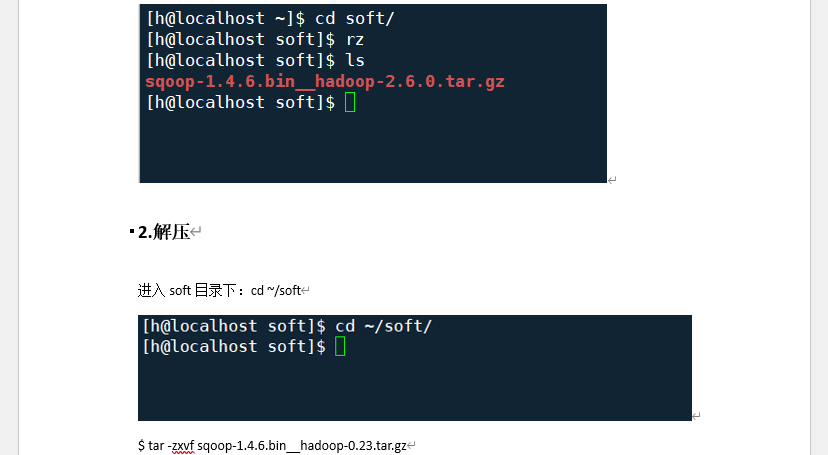

- 完成 Sqoop 安装包上传与解压,建立软链接简化后续操作;

- 配置 Linux 环境变量,确保 Sqoop 命令全局可调用;

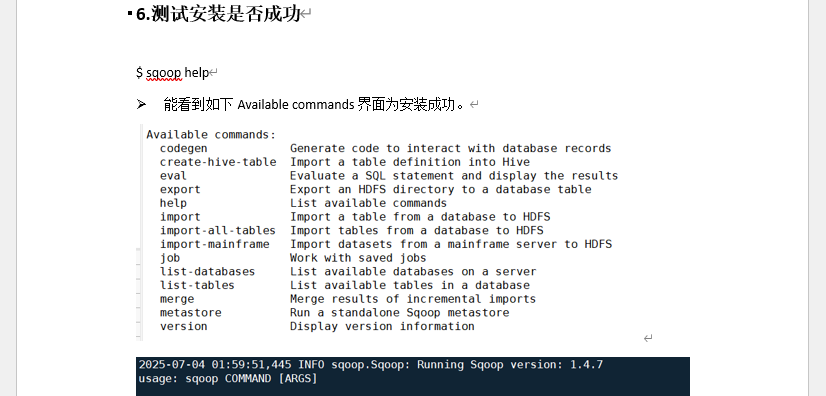

- 配置 MySQL 连接器,关联 Hadoop、Hive 环境,验证安装成功。

截图位置:安装包上传界面 | 环境变量配置页 | 安装成功验证页标题:图 1 Sqoop 安装配置关键步骤

2. 实验数据准备

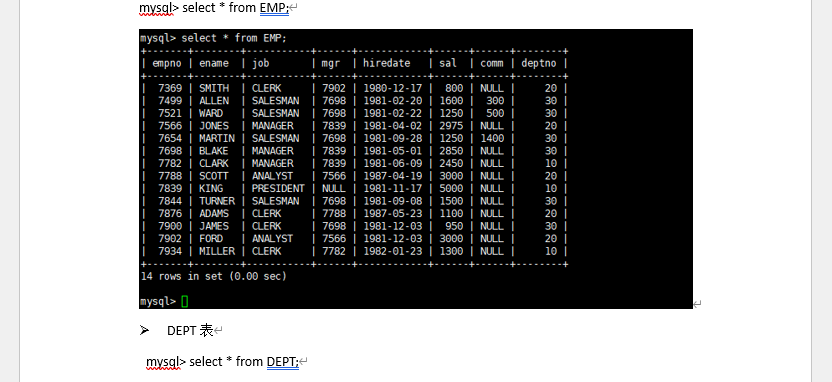

- 登录 MySQL,创建专属实验数据库与两张测试表(员工表 EMP、部门表 DEPT);

- 向两张表中插入符合实验需求的测试数据,验证数据插入结果。

截图位置:数据库与表创建界面 | 数据插入结果查询页标题:图 2 MySQL 实验数据准备

3. 核心实验:Sqoop 数据互导操作

通过 Sqoop 实现不同组件间的数据流转,覆盖课程高频实验场景,操作结果可直接用于实验报告验证。

(1)数据互导场景汇总

| 数据流转方向 | 核心操作目标 | 实验价值 |

|---|---|---|

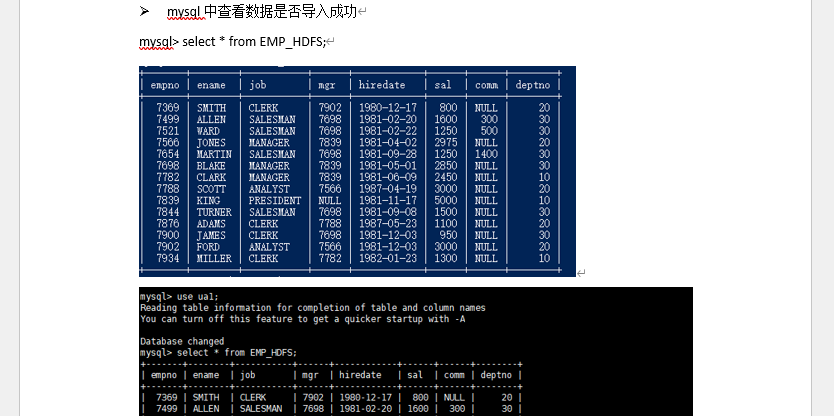

| MySQL → HDFS | 将 MySQL 中员工表数据导入 HDFS 指定目录 | 掌握结构化数据入 HDFS 方法 |

| HDFS → MySQL | 将 HDFS 中数据导出到 MySQL 新建表 | 验证 HDFS 数据复用可行性 |

| MySQL → Hive | 将 MySQL 表数据导入 Hive 并自动建表 | 实现结构化数据入数仓 |

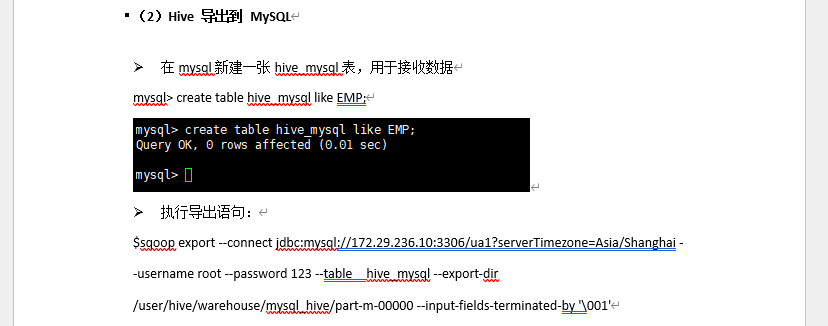

| Hive → MySQL | 将 Hive 表数据导出到 MySQL 新建表 | 完成数仓数据落地应用 |

截图位置:MySQL→HDFS 结果页 | HDFS→MySQL 验证页 | MySQL→Hive 操作页 | Hive→MySQL 结果页标题:图 3 Sqoop 数据互导全场景实战

三、文档样例截图

四、付费下载

文档含完整实验截图,步骤清晰无冗余,跟着操作即可完成所有实验任务,无需额外查资料。无论是课程实验提交,还是考前复习巩固,都能帮你高效搞定 Sqoop 实验!

获取完整文档:[点击付费下载《sqoop 的安装以及导数据实验.docx》](格式:docx,适配 Windows/macOS,可直接复制截图与步骤到实验报告)